- Clotûre des inscriptions

- dans

Days :

Hours :

Minutes :

Seconds

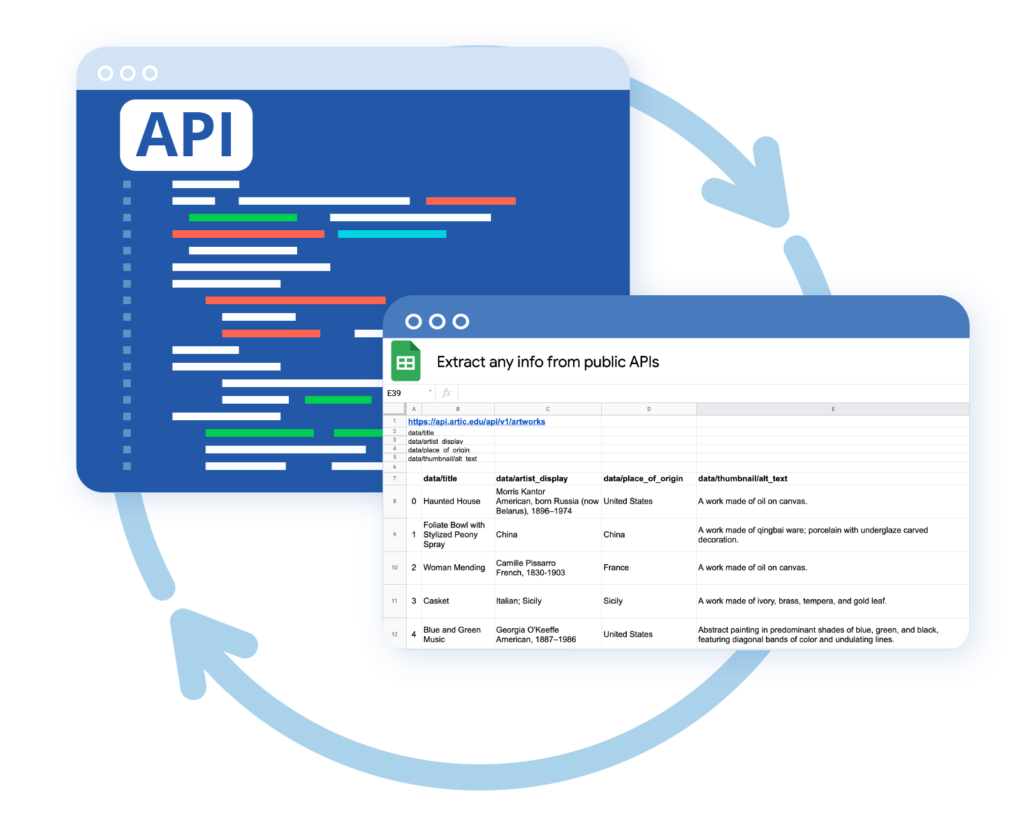

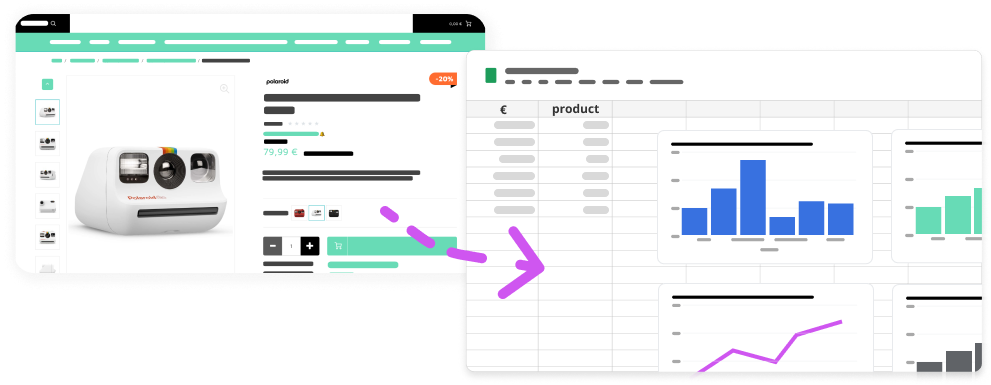

ScrapMe est un scraper de données web conçu pour collecter, croiser, manipuler et analyser des données web directement dans vos Google Sheets.

Vous pouvez récupérer des données de n’importe quel site web. Saisissez juste les URLs et les parties à scraper.

La seule limite c’est votre imagination.

Créer un compte gratuitement en quelques secondes

Copier le morceau de code (script) depuis votre espace perso

Coller le code ScrapMe dans Google Sheets (dans AppScript)

Ouvrir un fichier Google Sheets et utiliser la fonction =SCRAPME(url;xpath) pour démarrer le scraping

Un système de scraping qui change d’identité en permanence pour évité d’être blacklisté.

Scrapez une même page gratuitement autant de fois que vous voulez pendant 24h

Pour éviter de se faire blacklister son adresse IP et passer inaperçu

Pour simuler des visites plus naturelles car espacées de plusieurs secondes

Pour changer à chaque fois l’identité du navigateur et être plus discret

Encore une technique pour être plus discret et éviter d’être bloqué

Chaque page que vous scrapez est conservée 24h pour continuer à la scraper gratuitement pendant 24h

Pour vous aider à définir les datapoints à scraper, un système de raccourcis est disponible (ex: email, url, facebook, téléphone, etc)

Il existe des centaines de cas d’usages différents ! Quel est le votre ?

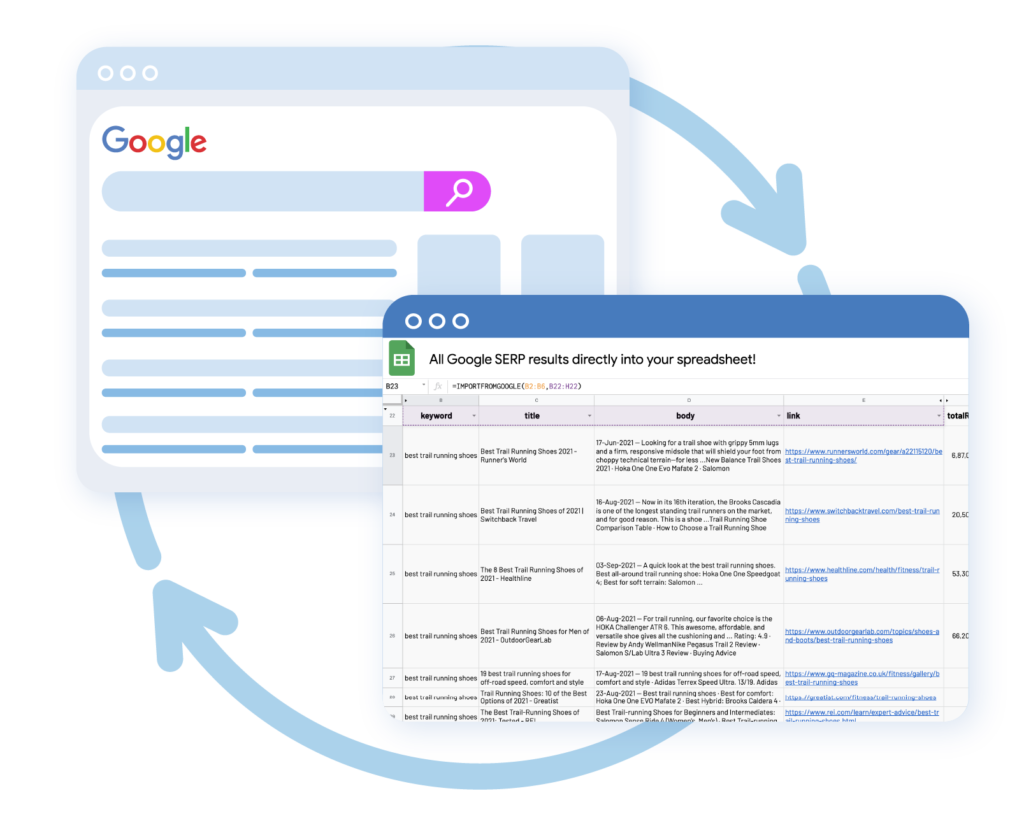

Améliorer les stratégies de référencement en analysant de manière plus approfondie les mots-clés, les liens et les autres tendances de recherche qui méritent d’être ciblées.

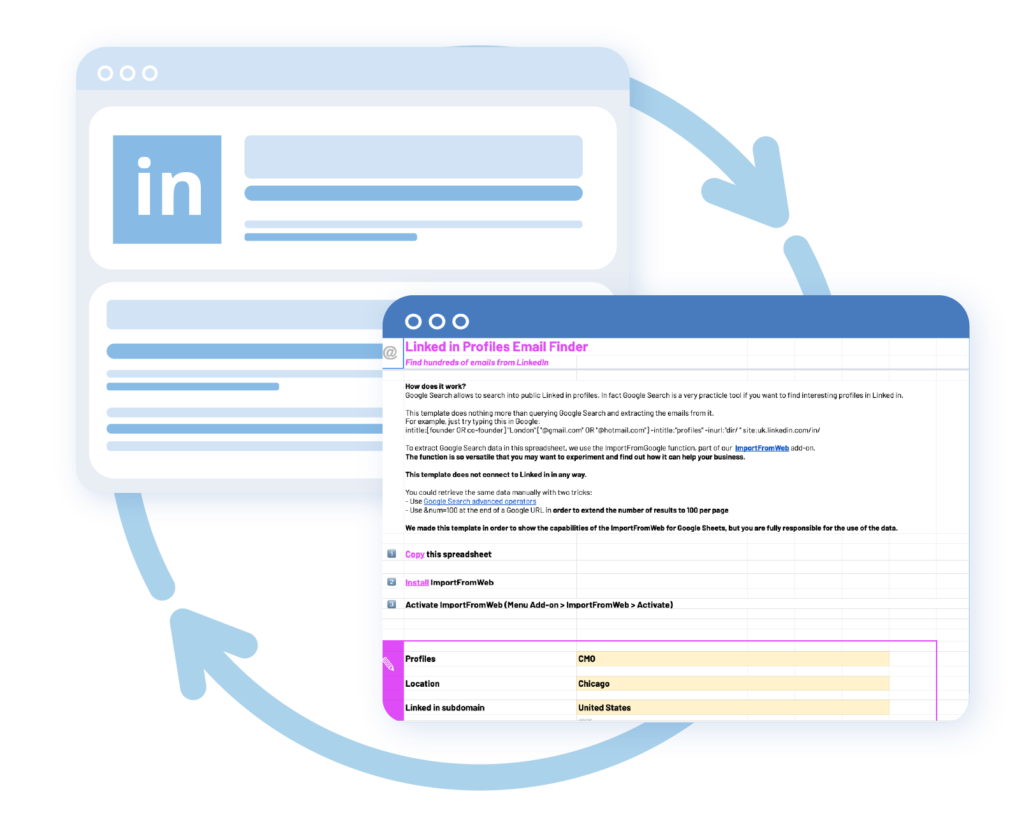

Créer des bases de données de prospects avec toutes les colonnes de votre choix (ex: nom, prénom, fonction, email, téléphone, description, etc)

Surveillez les informations provenant des milliers de pages à la fois. Facilitez l’accès à l’information et faites parler les data.

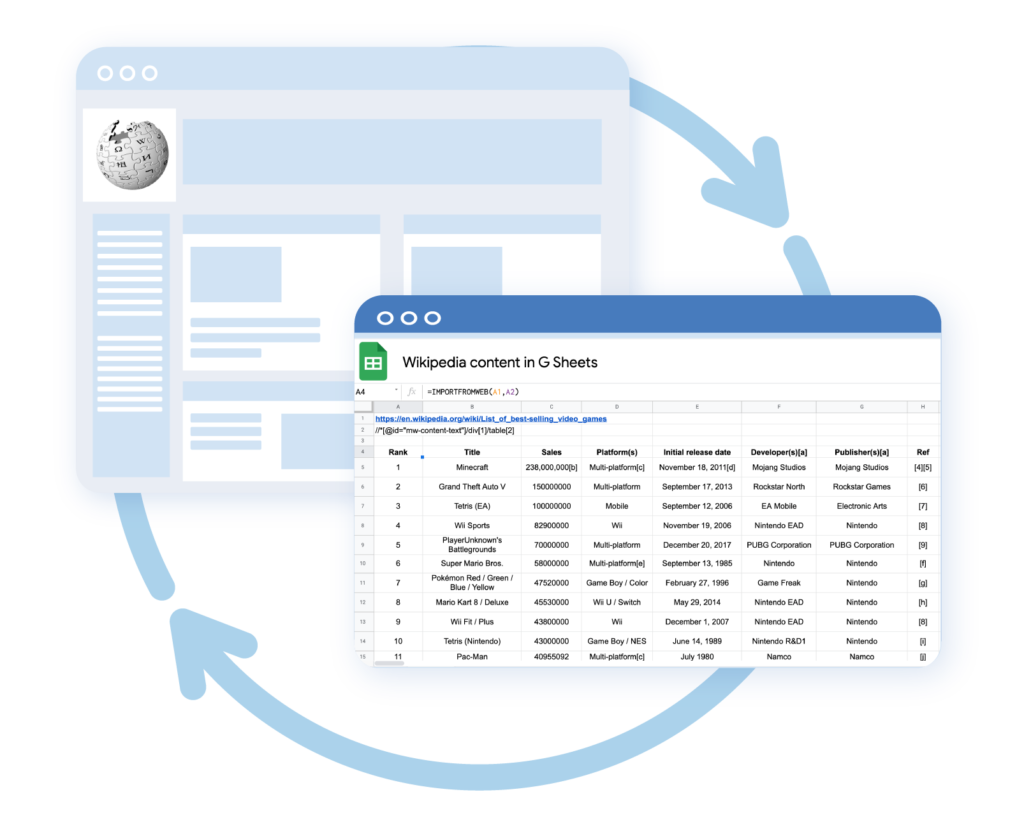

Agréger des données intéressantes provenant de milliers de sites web afin qu’elles soient digestes et prêtes à être analysées.

Restez au courant de tout ce qui concerne le contenu en surveillant les dernières tendances à partir de sources multiples et en gérant l’engagement avec du contenu de marque.

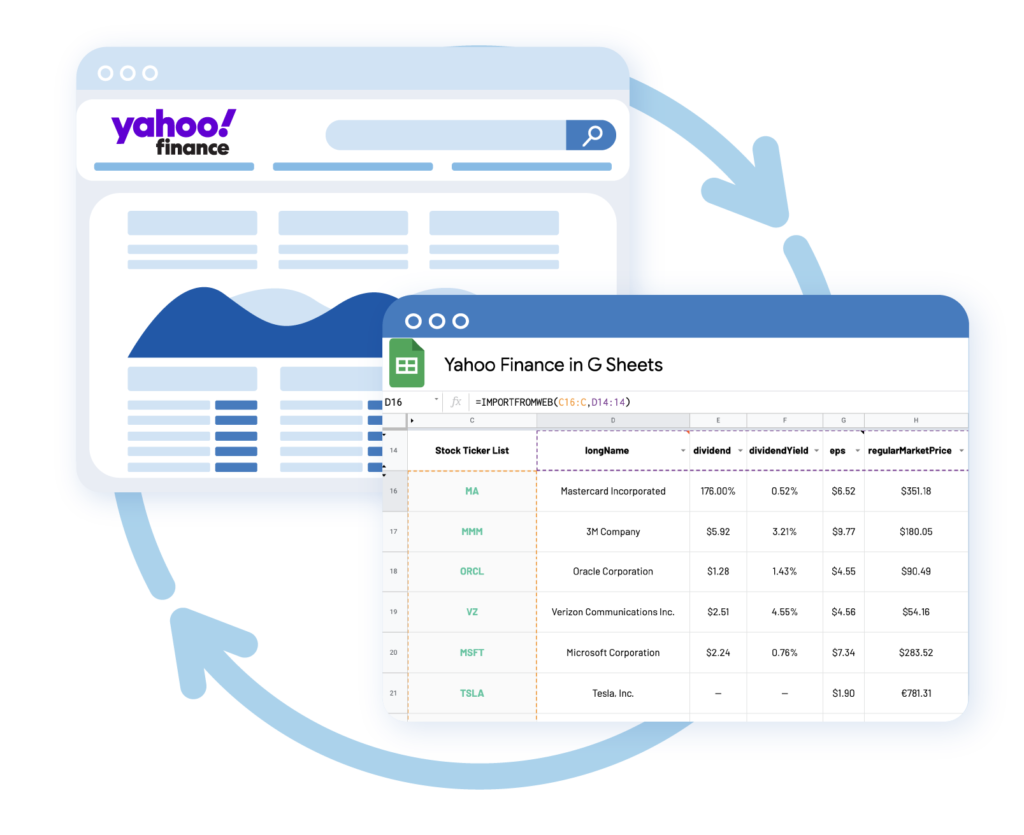

Suivre les tendances du marché, croiser les données et facilitez l’accès à l’information pour accélérer la prise de décision.

Rapide et fiable avec des milliers de pages et de points de données dans une seule feuille de calcul.

Aucun logiciel à installer. Facile à prendre en main. Commencez à scraper les pages web immédiatement.

Toutes les données scrapées donc directement intégrées dans Google Sheets. Un gain de temps considérable pour vos projets de scraping.

Ne soyez pas limité(e) à quelques centaines de pages à scraper. Scrapme vous permet de scraper plusieurs milliers de pages chaque mois.

Créez des tableaux de bord complexes et faites parler les données.

Simple et transparent. Scrapez des données chaque jour. Annulez à tout moment.

* Un datapoint est un champs de données dans une page web. Par exemple si vous scrapez sur une même page web: le titre, la description, l’email et le téléphone, il y a alors 4 datapoints. Pour une même page scrapée, vous pouvez donc récupérer autant de champs que vous souhaitez sans être facturé en plus pour cela.

Google possède sa version d’Excel qui s’appelle Google Spreadsheet.

ScrapMe est une fonction de scraping web qui s’intègre Google Spreadsheet. Cela vous permet de récupérer le contenu de n’importe quel site (ex: email, téléphone, nom, ville, description, etc) simplement à partir de l’URL. Vous pouvez ainsi récupérer (= scraper) des milliers d’URLs afin de récupérer des dizaines de milliers d’informations en quelques instants.

Il vous simplifie la récupération de données directement via Google Spreadsheet.

Contrairement à certains services existants qui vous bloquent au bout de quelques centaines d’URLs scrapées, avec les abonnement Premium de ScrapMe, vous pouvez scraper des milliers d’URLs chaque mois.

De plus, pour éviter d’être bloqué / blacklisté par certains sites web qui utilisent des systèmes de détection des bots de scraping, ScrapMe utilise un système pour passer inaperçu. Grâce à un système de rotation d’adresses IP, rotation user-agents (navigateurs web), rotation en tête http, utilisation de cookies, etc.

Cela permet de simuler une multitude d’utilisateurs différents plutôt que de laisser penser à un seul et même bot.

D’autre part, vous pouvez scraper des données non seulement à partir du Xpath mais aussi à partir de raccourcis tels que l’email, le téléphone, url facebook, titre de page, etc.

Vous devez d’abord créer un compte sur Arnowebtv.com en 20 secondes (c’est gratuit).

La fonction ScrapMe de Google Spreadsheet, coûte de l’argent lors du scraping de chaque URL.

Lorsque vous avez créé un compte gratuitement, vous pouvez l’utiliser pour scraper quelques centaines d’URLs.

Mais vous pouvez scraper plusieurs milliers d’URLs en prenant un abonnement Premium, Gold ou Diamond sur Arnoweb TV.

Copiez / collez ceci dans une cellule de Google Spreadsheet:

=SCRAPME("https://www.thewebsite.com";"//html/body/title")Il y a 2 paramètres:

– L’URL à scraper

– Le Xpath (ou le raccourci) qui correspond à l’emplacement exact dans la page.

Si vous scrapez beaucoup d’URLs à la fois, il faut que les pages utilisent le même template (même structure) afin que le Xpath fonctionne pour toutes les pages.

Comme vous pouvez le voir plus bas dans cette FAQ, il y a des raccourcis pour éviter de saisir le Xpath dans certains cas.

Dans la fonction ScrapMe, en plus de l’URL, vous devez indiquer l’emplacement exact sur la page qu’il faut récupérer pour l’importer dans votre fichier Spreadsheet.

Le Xpath ressemble à quelque-chose comme cela:

//html/title

//*[@id= »post-36″]/div/div/h1

Ca commence par le haut de la page HTML, jusqu’à l’emplacement exact au sein des sous sections HTML.

Pour l’obtenir:

1) Allez simplement sur la page que vous voulez scraper

2) Puis faites un clic droit -> « Inspecter » sur l’élément que vous voulez récupérer

3) La Toolbar qui s’est ouverte sélectionne l’élément HTML que vous avez sélectionné

4) Faites un clic droit sur cet élément HTML concerné, puis clique sur « Copier » , puis « Copier Xpath »

5) Ca y est ! Vous avez copier le Xpath qu’il vous reste à coller dans Spreadsheet

Oui c’est possible

Vous pouvez utiliser des raccourcis à la place du Xpath, spécialement conçu pour ScrapMe:

– title: pour afficher le titre de la page (onglet du navigateur)

– metadescription: la balise utilisée pour les moteurs de recherche

– h1: la balise titre principale de la page

– h2: la balise sous titre de la page

– email: le premier email présent dans la page

– emailall: tous les emails présents dans la page (séparés par une virgule)

– tel: numéro de téléphone dans la page

– url: première url détectée dans la page

– urlall: toutes les urls détectées dans la page

– facebook: première url Facebook dans la page

– facebookall: toutes les URLs Facebook dans la page (séparées par une virgule)

– instagram: première url Instagram dans la page

– instagramall: toutes les URLs Instagram dans la page (séparées par une virgule)

– linkedin: première url Linkedin dans la page

– linkedinall: toutes les URLs Linkedin dans la page (séparées par une virgule)

– twitter: première url Twitter dans la page

– twitterall: toutes les URLs Twitter dans la page (séparées par une virgule)

– tiktok: première url Tiktok dans la page

– tiktokall: toutes les URLs Tiktok dans la page (séparées par une virgule)

– video: première url contenant un fichier vidéo dans la page

– videoall: toutes les URLs contenant des fichiers vidéos dans la page (séparées par une virgule)

– music: première url contenant un fichier audio dans la page

– musicall: toutes les URLs contenant des fichiers audio dans la page (séparées par une virgule)

Vous pouvez utiliser le sitemap XML du site web concerné. (ex: www.siteweb.com/sitemap.xml)

Vous pouvez aussi utiliser mon App pour extraire des URLs. (améliorations à venir)

1 crédit est débité par URL scrapée tous les 24 heures.

Si vous scrapez exactement la même page plusieurs fois en 24 heures, ce n’est pas décompté. (par exemple pour récupérer le titre, email, nom, etc)

Au delà de 24 heures, l’URL scrapée débite à nouveau du crédit.

Cela veut aussi dire qu’il y a un système de cache de 24h. Si le contenu sur le site a été actualisé il y a moins de 24 heures, vous devrez donc attendre 24 heures pour que la nouvelle version de la page soit scrapée.

IMPORTANT: Si vous avez beaucoup de lignes qui utilisent la formule « ScrapMe », pensez impérativement à sauvegarder les valeurs extraites de votre Google Sheets dès que l’extraction est terminée. En effet vous avez 24h pour le faire sans quoi, cela relancera le scraping lorsque vous rechargerez votre fichier Google Sheet.

Pour cela:

1) Sélectionnez toutes les cellules où a été extrait le contenu

2) Faites « Copier »

3) Ensuite faire un « Collage spécial » -> « Valeur uniquement »

4) Voila vous avez sauvegardé les valeurs

Connectez-vous dans votre Dashboard

Ensuite cliquez sur « Afficher ma clé privée » -> Vous verrez ainsi votre clé privée (token) ainsi que le crédit restant.

Lorsque vous ouvrez un Google Spreadsheet que vous avez utilisé il y a plusieurs jours, cela est embêtant si toutes vos URLs sont de nouveau scrapées si vous aviez déjà récupéré le contenu…

Cela va vous couter du crédit, surtout si ces pages ont été scrapées depuis plus de 24 heures.

Pour remédier à cela:

1) Sélectionner toutes les cellules avec les contenus scrapés.

2) Faire un « Copier »

3) Faire « Coller les valeurs uniquement ». Cela permet d’écraser la formule par la valeur récupérée.

Cela permet d’écraser les formules ScrapMe afin de ne conserver que les valeurs obtenues.

Les sites web les plus populaires comme Google, Facebook, Amazon, etc utilisent massivement des systèmes anti-scraping.

(beaucoup d’autres sites aussi mais pas avec autant de moyens)

Ils investissent des millions d’euros dans des algorithmes & IA pour détecter les systèmes de scraping.

Il est donc possible (mais pas forcément) que vous rencontriez plus de difficultés pour scraper ces sites web bien que ScrapMe utilisent des systèmes pour passer inaperçu.

© 2023 Arnaud Guednée (alias Arnoweb TV)